Az online marketing nagy erőssége, hogy mérhető – de ez csak akkor jelent jót, ha értelmezni is tudod az eredményeket.

Ha kíváncsiak vagyunk arra, hogy két (vagy több) változat közül melyik működik jobban, A/B-teszteket használunk.

Ezek gyakorlatilag bármire jók: tárgymezőket, CTA-kat, akár dizájnelemeket vagy egy egész checkout folyamatot is A/B-tesztelhetsz.

Az A/B teszt segít optimalizálni a folyamataidat és megtalálni a leghatékonyabb megoldásokat, és így jobban megérteni a közönségedet. Segít felépíteni a buyer personát és igazítani a kampányodon.

Leegyszerűsítve így néz ki egy teszt:

- A tesztelendő elemből létrehozol 2 változatot. (Fölállítasz egy hipotézist.)

- A célcsoportodon belüli véletlenszerű mintán teszteled ezeket.

- Figyeled a válaszokat, eredményeket.

- A következő alkalommal már csak a jobb változatot használod.

Hasonlít a folyamat a közvélemény-kutatásra, és a best practice is éppen ezért hasonló. Ha hatékony A/B-tesztet akarsz futtatni, akkor meg kell felelnie bizonyos kritériumoknak.

Az alapvető követelmények

Egyszerre mindig csak egyvalamit tesztelj.

Ha nem így teszel, torzulnak az eredmények: ha egy hírlevél feladóját és tárgymezejét is megváltoztatod, nem fogod tudni, melyiknek köszönheted az esetlegesen nagyobb megnyitási arányt.

A teszt fusson párhuzamosan.

Ha hírlevelet tesztelsz, egyszerre küldd ki mind a két változatot. Ha egy érkeztetőoldal CTA-ját, egyszerre mutasd meg a véletlenszerűen elosztott felhasználóknak mindkét változatot.

Az eltérés is torzíthat az eredményeken: képzeld el, hogy egy hírlevél két változatát tesztelnéd, és az egyiket december 20-án, a másikat 24-én küldöd ki. Valószínűleg radikálisan eltérő adatokat kapsz majd, de nem tudni, miért: azért, mert változtattál, vagy mert éppen karácsony van.

Több olyan nem publikált teszt van a tarsolyunkban, amikor ügyfeleink 1 hét (vagy még nagyobb) eltéréssel küldtek ki egy-egy anyagot. Érdekességnek jó az ilyesmi, de az eredmény használhatatlan.

A teszt elég ideig fusson – legalább 1 hétig.

Hírlevél esetén ez pont nem érvényes, de ha egy landing oldalon, blogon vagy más weboldalon tesztelsz valamit, akkor lehetőség szerint legalább egy hétig fusson aktívan és párhuzamosan a teszt. Ez segít az esetleges torzítás lefaragásában.

A minta legyen szignifikáns (min. 1000 fő).

A közvélemény-kutatók általában 1000 fős mintát kérdeznek, és mi sem tanácsolunk mást. Nagyjából ez az a határ, ahol már azt mondhatod, hogy megbízható adatokat kapsz, mert a véletlenszerűen kiválasztott felhasználók között minden szegmens, minden buyer persona megfelelő arányban képviselteti magát.

Ezeket figyelembe véve kell beállítanod a tesztet. Ha nem így teszel, akkor végül az eredményekben nem bízhatsz majd.

Tegyük fel, hogy két srác elindul a siófoki éjszakában. Mind a ketten meg vannak róla győződve, hogy ők jobban bejönnek a lányoknak, ezért elkezdik leszólítani és megkérdezni őket. Az első három lányból egy A fiút, kettő B fiút választja.

Ha a tesztet itt lezárják, akkor az eredmények azt mutatják, hogy a B változat konverziója 100%-kal magasabb az A változaténál, mert a minta 66,6%-a ezt választotta.

De ezen a ponton biztosak lehetünk-e abban, hogy ez nagyobb mintára vetítve is igaz marad?

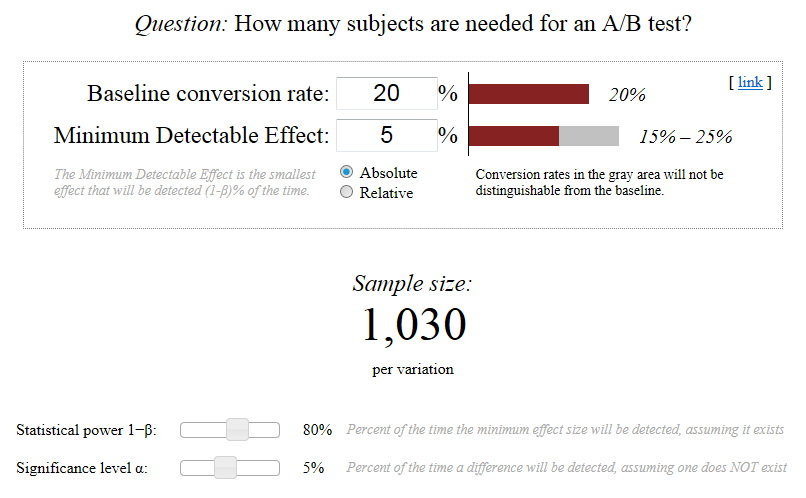

Meghatározni azt, hogy mekkora legyen a megfelelő minta, nem egyszerű – adott persze a best practice, de a kiinduló helyzet és az elvárt eltérés tekintetében ez változhat.

E mögött már bonyolultabb matematika is áll, de szerencsére neked nem kell a képletekkel bajlódni. Számos remek online eszköz áll rendelkezésedre, így például Evan Miller ingyenesen használható kalkulátora.

A hibahatár

Valószínűleg találkoztál már ezzel a szimbólummal: ±

Ez minden bizonnyal valamilyen statisztikai jellegű eredmény kapcsán, mondjuk egy közvélemény-kutatásnál történt. Ez ugyebár a plusz-mínusz, és azt jelzi, hogy egy adott vizsgálatnak mekkora a hibahatára.

Ha például azt mondjuk, hogy A változat eredménye a teszt után 30±4%, az azt jelenti, hogy reálisan a közönséged 26–34%-a választja majd ezt szívesebben. (Bonyolítja a matematikai helyzetet, hogy a százalék és százalékpont nem ugyanaz: ha valaminek a 10 százaléka 2%-kal növekszik, akkor 10,2%-ról beszélünk, ha viszont 2 százalékpontot, akkor 12%-ról.)

Tehát, hogyan határozhatod meg, hogy mekkora hibahatárral dolgozz?

Trükkös kérdés.

Egyrészt, nagyjából bizonyosan onnan tudhatod, hogy mekkora a hibahatár, ha bizonyos teszteket egymás után többször is elvégzel, és megfigyeled, hogy mennyire térnek el egymástól az eredmények. A tapasztalati út azonban nem mindig működik: nem végezheted el ugyanazt az A/B-tesztet egymás után többször is minden alkalommal, hiszen más teszteket is futtatnod kell, és az időd véges.

A hibahatárt alapvetően úgy határozzuk meg, hogy belőjük azt az intervallumot, amelyen belül úgy véljük, hogy a mintától kapott válaszok 95%-a elhelyezkedik majd.

A fenti esetben ez az intervallum a 26–34% – ezt nevezzük konfidencia-intervallumnak. Ez mindjárt fontos lesz.

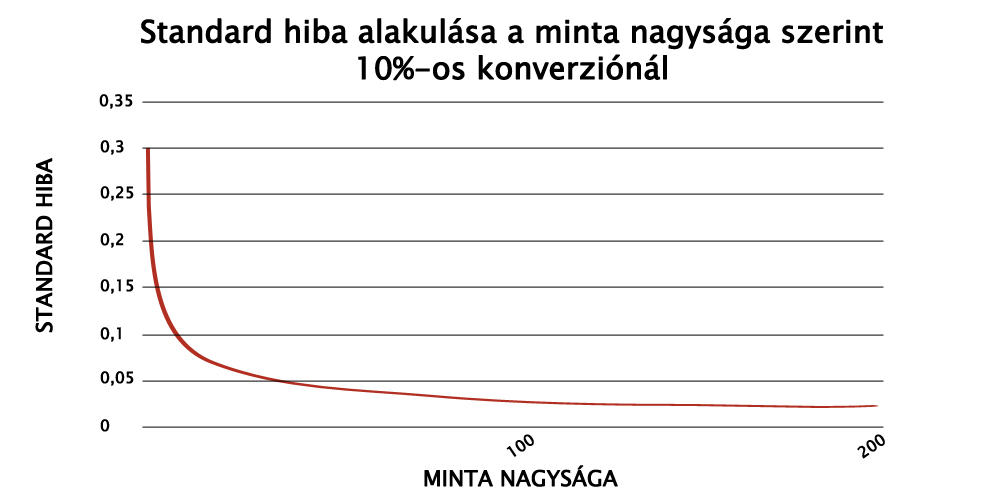

Minél több adatot gyűjtünk be, minél nagyobb mintán dolgozunk, annál kisebb lesz ez az intervallum, annál kisebb hibahatárral számolhatunk.

- 1%-os hibahatár azt jelenti, nagyon biztos lehetsz az eredményben.

- 5%-os hibahatárnál nagyjából biztos lehetsz benne.

- 20%-os hibahatárral már nem sok értelme van, tovább kell tesztelned.

A szerencséd, hogy a hibahatárt a szoftverek automatikusan megmondják neked, ez ugyanis egy képlettel a minta szórásából és nagyságából adódik. (A fenti kalkulátorban éppen ezért adhatod meg, hogy mekkora legyen a legkisebb mérhető eltérés: ez gyakorlatilag azt adja meg, mekkora a maximális elfogadható hibahatár.)

Ha konfidencia-intervallumok találkoznak

Tételezzük fel, hogy mind az A, mind a B variáns esetén viszonylag kicsi az intervallumunk, tehát az egyes variánsokra vonatkozó adatokban megbízhatunk.

Vegyünk egy példát:

- A variánsnál a konverziós arány 10%±0,5%

- B variánsnál a konverziós arány 11%±0,8%

Ez azt jelenti, hogy a két intervallumunk így alakul:

- 9,5–10,5%

- 10,2–11,8%

Ez gond. A két intervallum között ugyanis ebben az esetben átfedés van (10,2%–10,5% között), és nem lehetünk biztosak benne, hogy a valóságban van bármilyen különbség a kettő között, mert lehet, hogy a valós érték mondjuk mind a két esetben 10,3%.

Ha a konfidencia-intervallumok fedik egymást, akkor két következtetés adódik:

- Nincsen szignifikáns különbség a két változat között

- Nem elég nagy a minta ahhoz, hogy ez megmutatkozzon.

Ha biztos vagy abban, hogy az eltérés jelentős és eredményt kellene hozzon, akkor folytasd a tesztelést. Ha úgy gondolod, hogy felesleges volna, akkor válaszd a valamennyire jobban teljesítőt – mivel a teszt nem hozott eredményt, akár véletlenszerűen is választhatnál, de még mindig ezzel lehet nagyobb esélyed.

Ha szignifikáns eltérést akarsz…

…vagyis sikeres tesztet, akkor eleve olyasmit kell tesztelned, aminél ez várhatóan jelentkezik.

Az A/B-tesztek egyik komoly problémája, hogy javarészt saját feltételezéseket, különösebb alap nélküli hipotéziseket tesztelünk.

Egy fokkal jobb ennél, ha más best practice-ek vagy éppen saját kutatás alapján készítjük el a két változatot.

A A és a B változat mindig térjen egy egymástól – nem feltétlenül radikálisan, de elég jelentősen ahhoz, hogy az befolyásolja az eredményt. Ez nem tudom neked számszerűsíteni, de szemléltetni igen.

- Ha egy tárgymezőben egy szinonimával helyettesítesz egy szót, az valószínűleg nem hoz majd komoly eredményt.

- Ha szögletes helyett lekerekített gombot használsz, az sem.

- Ha egy blogposzt 1000 helyett 1100 szavas, az sem.

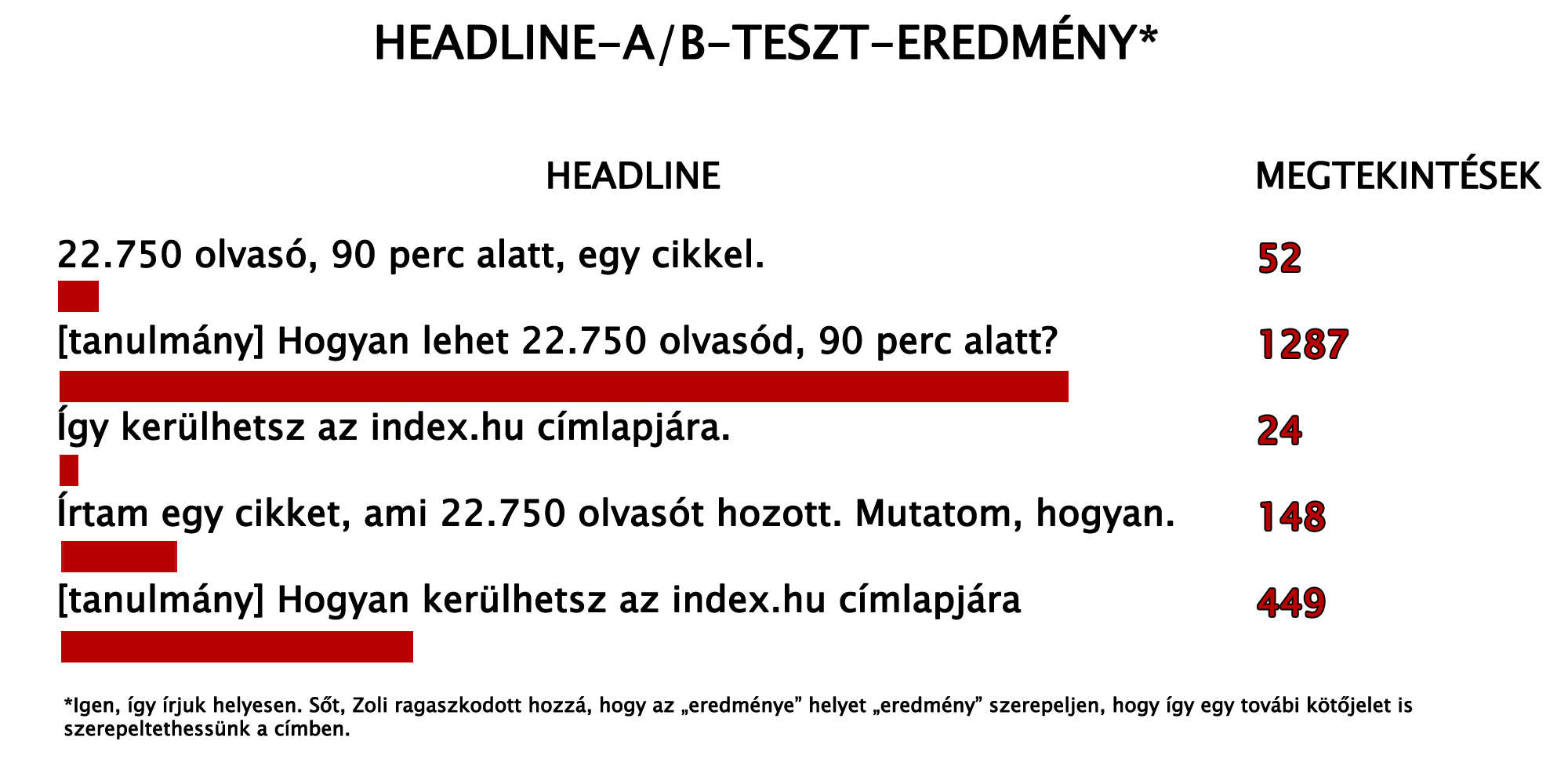

Nézd meg ezeket a posztcímeket. Nem csak egy-egy szó változik bennük, hanem a teljes cím átalakul minden alkalommal, ezért a teszt nagyon komoly eredmény is hozott:

Ha kíváncsi vagy, mi ez pontosan, az új Kontent Magazinban egy elképesztően részletes esettanulmányt találsz.

Relatív és abszolút eltérés

Tételezzük fel, hogy

- A variáció 1%-os konverziót hoz,

- B variáció pedig 2%-osat.

Alapvetően ez a különbség nem tűnik nagynak, de tételezzük fel azt is, hogy nagy mintán, nagyon kis hibahatárral dolgozunk. (Mondjuk méregdrága jachtot kínálunk 20 ezer embernek.)

Az abszolút eltérés persze mindössze 1%. Ez az egyetlen százalék azonban egyben azt is jelenti, hogy a B variáció kétszer annyi konverziót hozott, mint az A.

A relatív eltérés ebben az esetben tehát 100%.

Ez már nagyon is szignifikáns különbség, tehát mindig ezt kell figyelned azzal együtt, hogy átfedésben vannak-e az intervallumok.

(Itt most feltételezni fogom, hogy a százalékszámítás módját ismered, ezért ezt nem fogom részletesen elmagyarázni.)

Miért fontos mindezt értened?

A legtöbben sajnos nem értenek a statisztikához. Közéjük tartozom én is, nem véletlenül írással foglalkozom matematika helyett.

Ezeket az alapfogalmakat azonban nekem is, neked is értenünk kell. Hiába mutat ugyanis a szoftver jó adatokat, ha azokból nem derül ki számodra, hogy tulajdonképpen melyik változatot érdemes alkalmaznod, vagy egyáltalán eredményes volt-e a teszt.

Ha mindig csak feltételezésekkel élsz, és csak az analitikát bámulva próbálod kitalálni, mi működik jól, nem érsz majd el olyan hatékonyságot, mintha folyamatosan A/B-tesztelnél.

Hadd adjak még egy utolsó jó tanácsot.

Mindig bölcsen válaszd ki, mit fogsz A/B-tesztelni.

Mindent tesztelhetsz, de nagyon kevés olyasmi van, ahol ennek tényleg van értelme. Egy e-mail esetében a tárgymezőt mindenképpen érdemes, de az utóiratot már nem. Egy landing oldalon a CTA vagy a headline tesztelése komoly eredményt hozhat, egy rövid bekezdés lecserélése középen viszont kevéssé valószínű.

A tesztelésre nagyon is véges alkalmad kínálkozik, hiszen egyszerre csak egyvalamit tesztelhetsz.

Válassz tehát okosan, és tanuld meg értelmezni az adatokat, mert csak így teheted költséghatékonnyá a marketingedet.

Show More